ラッソ

最近色々ラッソについて調べていたんですが、微分不可能な関数の最適化ってやっぱ難しいですね。機械学習において非常に重要な2つのキーワード – ラグランジュの未定乗数法 – KKT条件 は別の記事でゆっくり解説します。では本題に入りましょう。Lasso

過学習を考慮した回帰モデルの一つ – L_1正則化項を使用した回帰model – スパース性を考えるときに用いる(これについては次の記事で詳しく説明します。) (1) ![]()

微分できない?

ちょっと微分について復習しよう。おまけで複素解析も出てくるよL1とL2

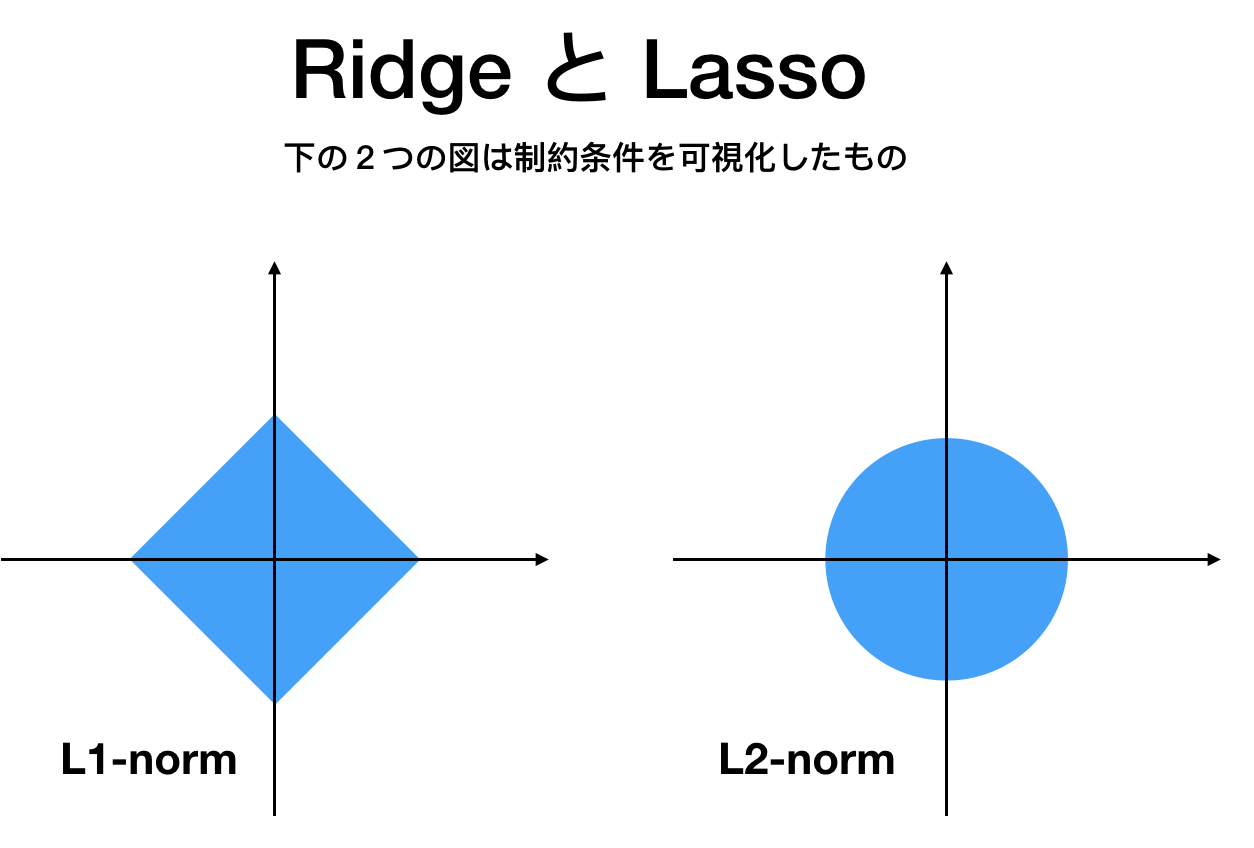

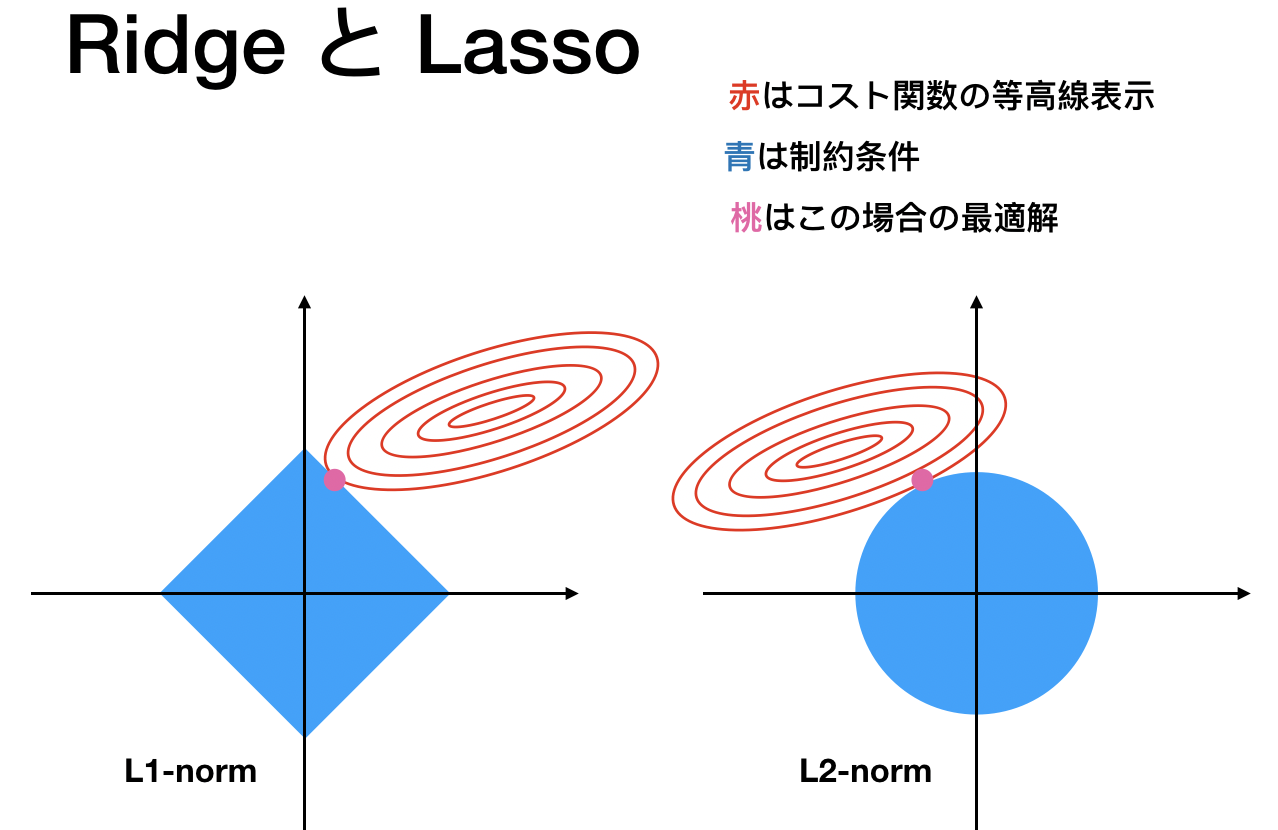

これまでに何度か説明していると思いますがまずは – 微分可能性 が大きな違いです。L1は尖っているので0で微分できませんね。他の違いは?

リッジ回帰ではデカイパラメータ

パラメータが0を図から考察

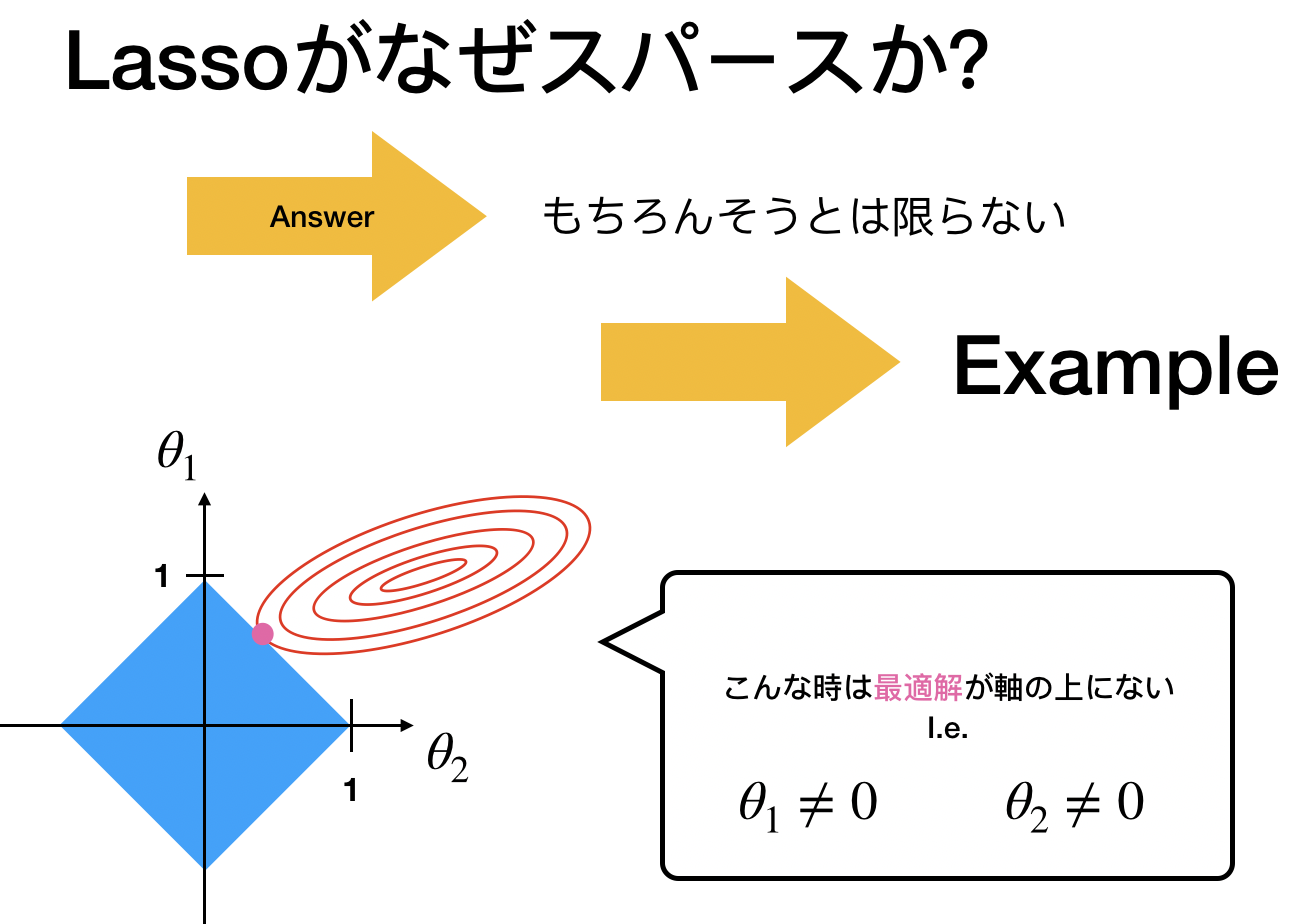

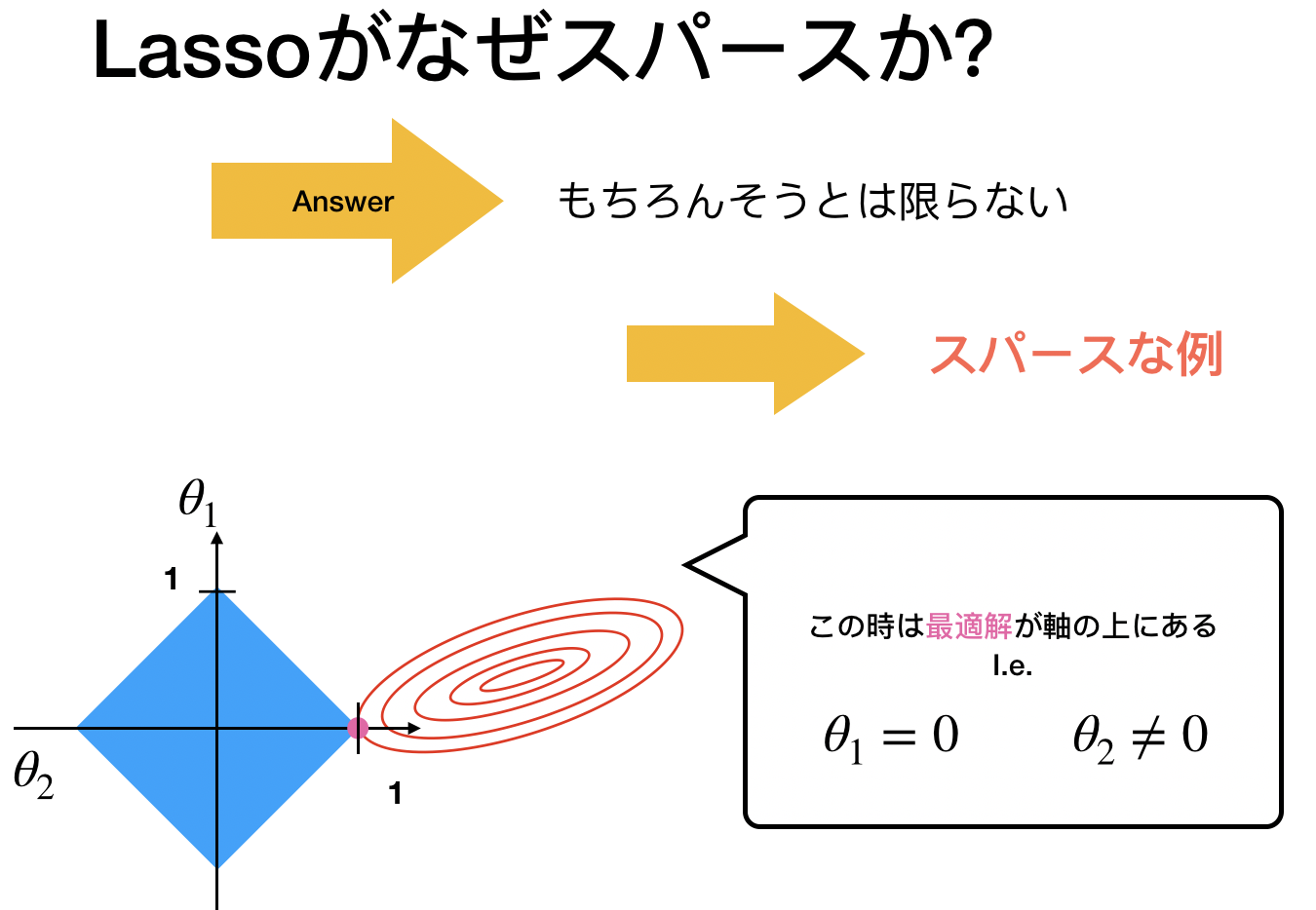

では図を用いて直感的に理解しましょう。次の図はRidge, Lassoを議論するときに使われるとてもポピュラーなものです。

「スパース」とは「スカスカ」なイメージ

つまり、ゼロがいっぱいあるイメージでいい。 しかし重要なのは常にスパースなわけじゃないこと。 スパースと言われるのはこの「尖ったポイント」に最適解がある時。

スパースと言われるのはこの「尖ったポイント」に最適解がある時。

これはL1だからできますよね。L2は円だったのでスパース性はありません。

これはL1だからできますよね。L2は円だったのでスパース性はありません。

パラメータが0を数式から考察

次のように超シンプルな回帰モデルを考えます。(以下転置使ってますが無くてもいいです) (2) ![]()

(3) ![]()

ここで解が![]() と仮定します。

と仮定します。

仮定より今は微分できます

(4) ![]()

(5) ![]()

一方、リッジの場合は

(6) ![]()

(7) ![]()