- Gradient descent (ascent)

- Batch gradient descent

- Stochastic gradient descent

- Mini-batch gradient descent

- Momentum

- AdaGrad

- Adam

- Adadelta

- RMSprop

そもそも「勾配」ってなんや?

って思いませんか?僕も初めの方は無意識で勾配を扱っていました。勾配の定義をまず確認しましょう。ベクトル解析におけるスカラー場の勾配(こうばい、英: gradient; グラディエント)は、各点においてそのスカラー場の変化率が最大となる方向への変化率の値を大きさにもつベクトルを対応させるベクトル場である。簡単に言えば、任意の量の空間における変位を、傾きとして表現(例えば図示)することができるが、そこで勾配はこの傾きの向きや傾きのきつさを表している。 (from wiki)わかりずらい!シンプルに言うと関数の変化率が最も大きくなる方向を勾配ベクトル(勾配)と言います。 証明はテイラー展開すれば簡単にできます。テイラー展開を少しだけおさらいすると局所的に関数を見たいときに使うんでしたね。厳密な証明はググれば山ほど出てくるのでここではメチャ雑に示します。

![]()

![]()

![]()

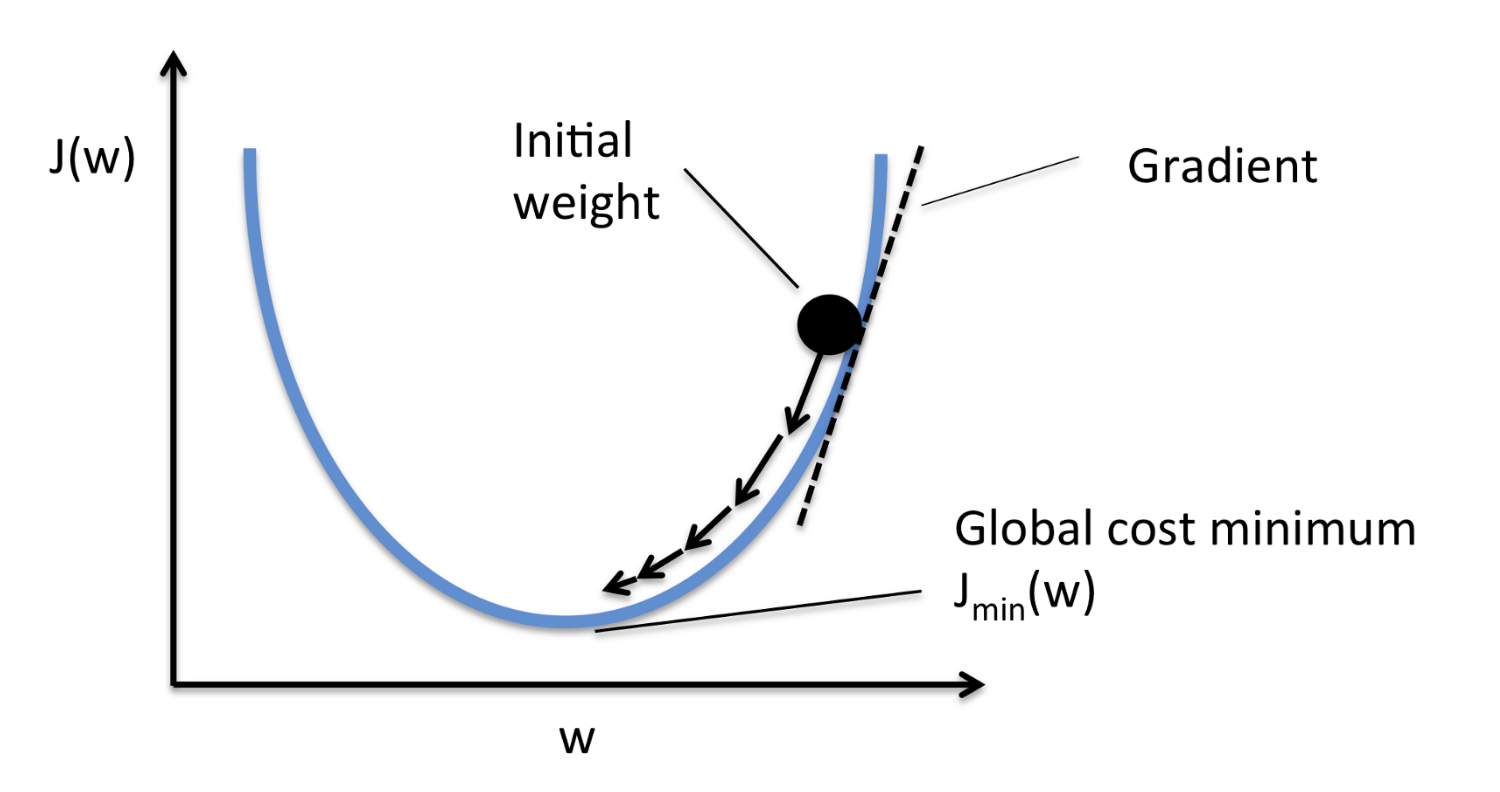

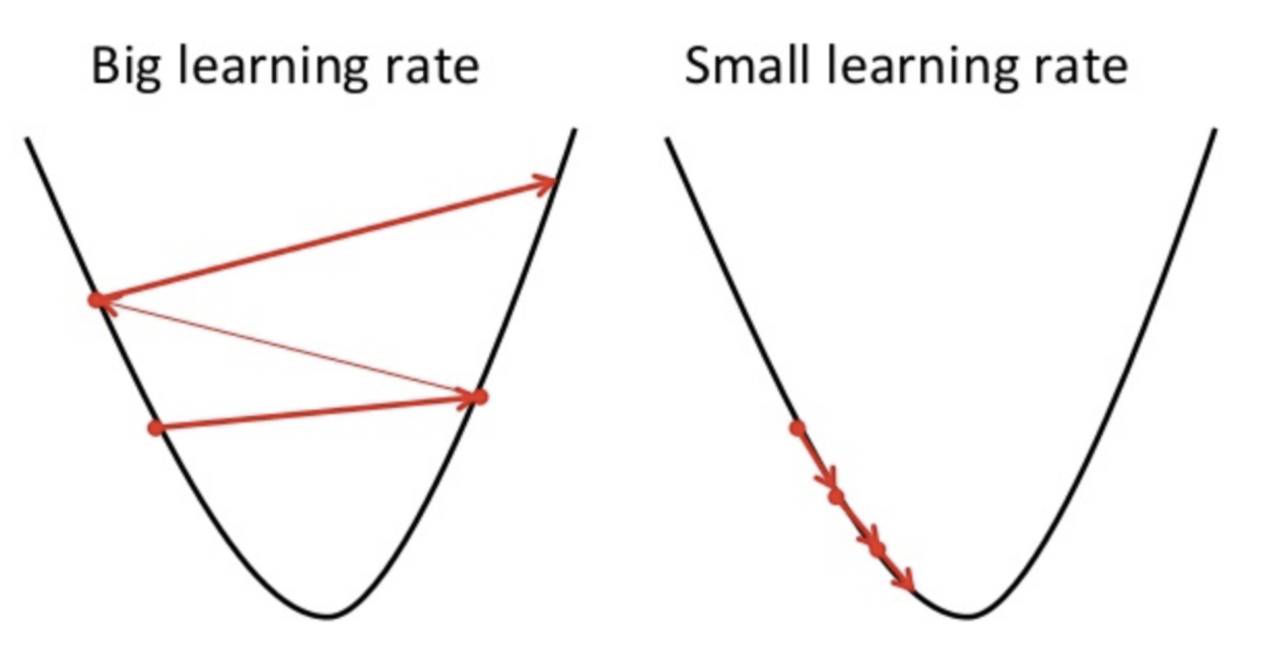

THE 勾配法

行ってみましょう。勾配法とは目的関数を最適化するための局所解を見つける手法のことです。簡単なイメージを持ってもらうためにしたの図を用意しました。 勾配(gradient)を使って関数の極小値・極大値を見つける方法です。ニュートン法とちょっと似てます。式で書くと次のようになります。

勾配(gradient)を使って関数の極小値・極大値を見つける方法です。ニュートン法とちょっと似てます。式で書くと次のようになります。 ![]()

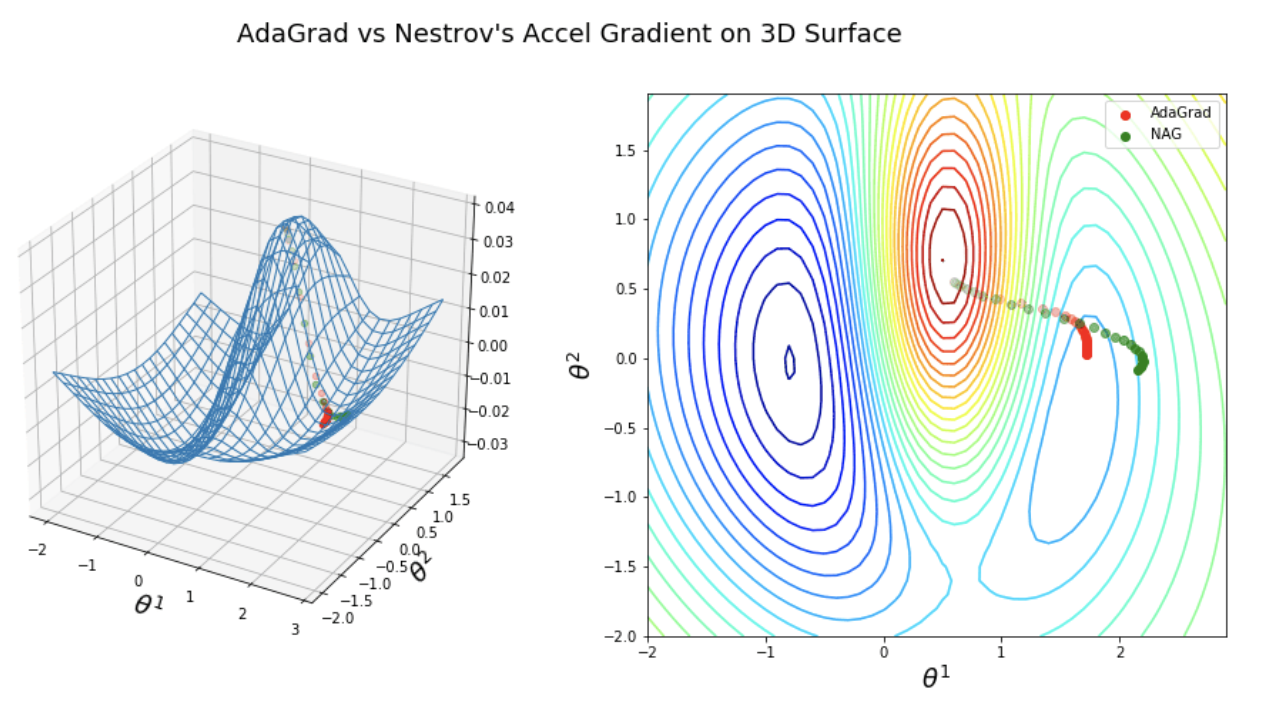

左のplotを等高線で表したものが右の図になります。機械学習では等高線の図は頻繁に見るので慣れてない方は慣れた法がいいです。赤い点と緑の点が異なる勾配法による最適解の軌跡です。ほんとは左の方がこの図だと最適解なんですが右のくぼみに進んでいますね。

数学ちっくな人はこの数列について収束するのか、と疑問を持った人もいるでしょう。

:http://www.stat.cmu.edu/~ryantibs/convexopt-F13/scribes/lec6.pdf

:https://perso.telecom-paristech.fr/rgower/pdf/M2_statistique_optimisation/grad_conv.pdf

例えばこことかに書かれているので興味がある方は読んでみてください。ニュートン法の時の証明結構めんどうだったのでたぶんこっちも結構ヤバそう。。。。。

とりあえず今回で勾配法が何かを理解できたと思います。次回はがっつりコード書きましょう!

引用:

左のplotを等高線で表したものが右の図になります。機械学習では等高線の図は頻繁に見るので慣れてない方は慣れた法がいいです。赤い点と緑の点が異なる勾配法による最適解の軌跡です。ほんとは左の方がこの図だと最適解なんですが右のくぼみに進んでいますね。

数学ちっくな人はこの数列について収束するのか、と疑問を持った人もいるでしょう。

:http://www.stat.cmu.edu/~ryantibs/convexopt-F13/scribes/lec6.pdf

:https://perso.telecom-paristech.fr/rgower/pdf/M2_statistique_optimisation/grad_conv.pdf

例えばこことかに書かれているので興味がある方は読んでみてください。ニュートン法の時の証明結構めんどうだったのでたぶんこっちも結構ヤバそう。。。。。

とりあえず今回で勾配法が何かを理解できたと思います。次回はがっつりコード書きましょう!

引用: