正則化とはなんぞや

名前が似てますね、ということは勾配法に関係あり?学習速度に関係あり?

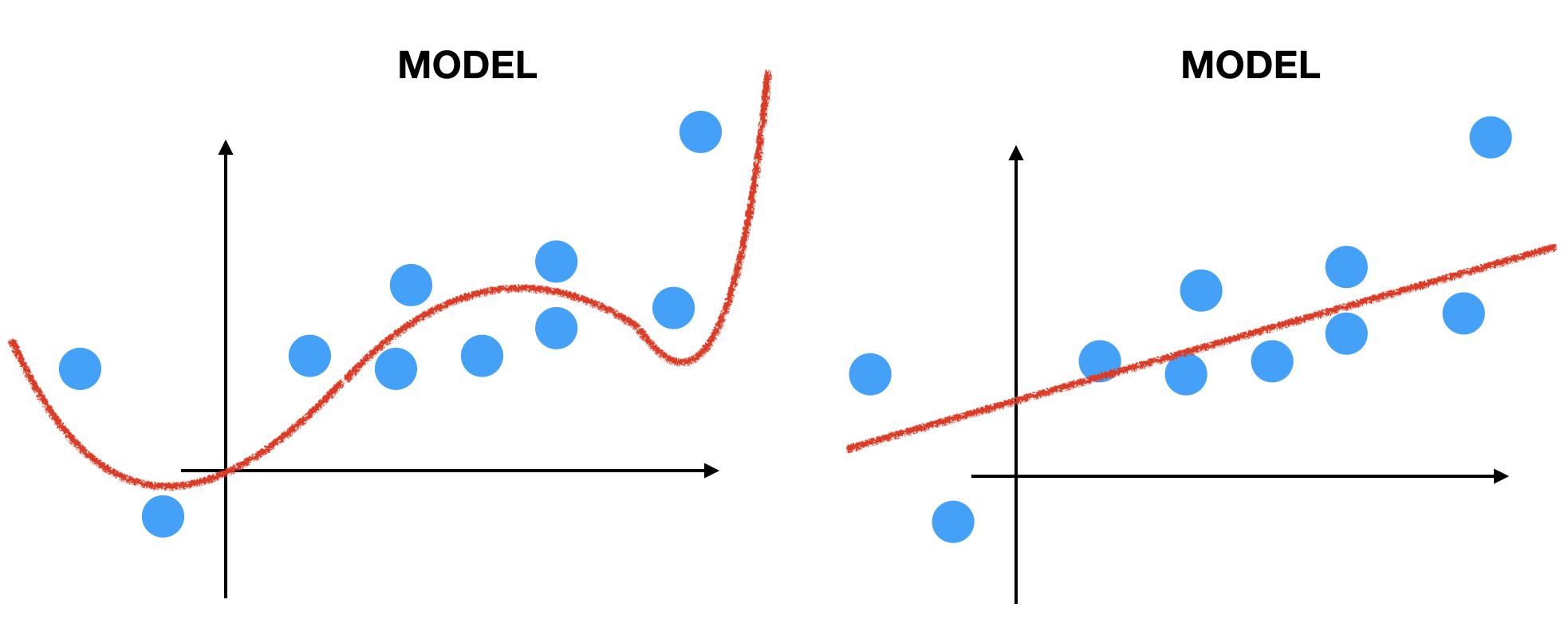

いい読みです。次の図を見てください。 どっちの曲線が「いい学習」をした結果だと思いますか? もう一問

どっちの曲線が「いい学習」をした結果だと思いますか? もう一問

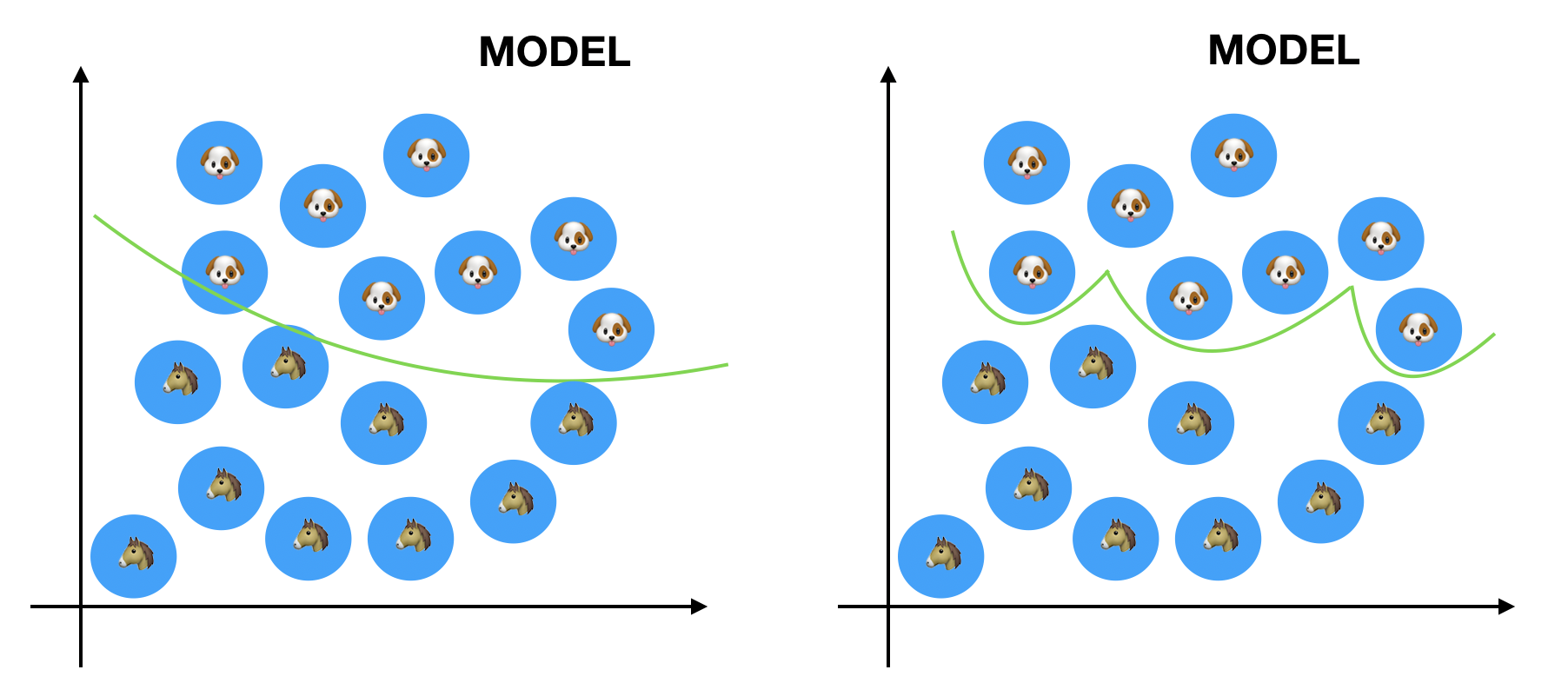

どちらが「いい分類」をしていますか?

どちらが「いい分類」をしていますか?

「いい分類・いい学習」とは何か?

を考える必要があります。データには誤差がつきものです。なので「誤差を許容するという寛大な心が必要」なんです。つまり、モデルは柔軟性を持つべき

という考えから「正則化」とう考えに突入します。具体的には?

そもそもなんで過学習してしまうのか、ですよね。あるモデルが過学習するということはパラメータが手持ちのデータを重視しすぎるということ

言い換えると過学習とはモデルが未知のデータを考慮しなくなるということです。

このままではいけません。未知のデータを考慮させる必要があり、そのための作戦が「正則化」です。具体的にはパラメータの学習に制限を設けること

です。例えば、パラメータ ![]()

![]()

![]()

![]()

制約が不等式!!!

これはやばいです。しかし! KKT条件という物を使えば解決します。(ちなみにSVMとかでも出てきますがかなり難しいです)(ちなみに制約が等式の時はラグランジュの未定乗数法)つまり ![]()

Lpノルムって何?

![]()

![]()

- Ridge Regression (Tikhonov regularization)

- Lasso Regression

![]()

![]()