こんにちは。

料理にはまっているkzです。

本日はリッジ回帰行きましょう。次回実装します。?

Ridge Regression

過学習を防ごうということで導入された正則化回帰の一例。

– ![]() 正則化項を使用した回帰model

正則化項を使用した回帰model

– パラメータに上限あり

たまにリッジ回帰はペナルティーありの線形回帰という記事を見かけますがそうではなく多項式回帰でもあります。つまりモデルが

(1) ![]()

だけでなく

(2) ![]()

もOKということ。

Notation

- Number of data:

- Dimension:

- Parameters:

つまり各データは

(3) ![]()

と表されます。![]() も同様。

も同様。

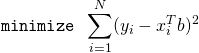

Constrained minimizationは

(4)

(5)

となりますが扱いずらいのでベクトル表示に変更し同時にKKT条件より最適化問題を同値なものに書き換えます。

(6) ![]()

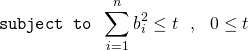

ではまず解を求めましょう。いつも通り微分をゼロとおいて解くだけ。今回のコスト関数は次の通り

(7) ![]()

として![]() で微分する。

で微分する。

– 「ベクトルで微分・行列で微分」公式まとめ

(8) ![]()

したがって

![]()

![]() は正則をキープするためのものでしたね。

は正則をキープするためのものでしたね。

ここまでは前回の内容をちょっとだけ丁寧にやっただけのおさらいのようなものです。ここからが数学チック。

さて、この解が最適解かどうかを関数の凸性から確認してみましょう。凸性は前回やりましたがお椀型なら極小値が最小値になることでしたね。

– 第2章 凸関数

– Convex functions

(9) ![]()

に対して次は同値である。

– ![]() が凸である

が凸である

– ![]() に対してヘッセ行列

に対してヘッセ行列![]() がpositive-semi-define

がpositive-semi-define

では

(10) ![]()

となりますね。ここでこれがpositive-semi-defineであることは次からわかります。![]() に対して

に対して

(11) ![]()

とノルムの定義よりわかりました。

今見たのは

(12) ![]()

の凸性ですよね。そして

(13) ![]()

こちらは明らかに凸。では![]() が本当に凸かどうか。これは直感的には明らかですが証明が簡単なのでやってみましょう。

が本当に凸かどうか。これは直感的には明らかですが証明が簡単なのでやってみましょう。

集合![]() を定義域とする関数

を定義域とする関数![]() がともに凸関数であると仮定する。

がともに凸関数であると仮定する。

このとき![]() に対して

に対して![]() が凸であることを示す。

が凸であることを示す。

(14) ![]()

(15) ![]()

(16) ![]()

Q.E.D.

Lassoは結構めんどくさいんですよね。。

でわ